Hace poco comenté los recuerdos que me traía la decisión de Sebastian Thrun de dejar Stanford para fundar una empresa e impartir cursos masivos y gratuitos en la Red sobre computación. Hoy he leído que su modelo de negocio es vender los datos sobre el desempeño de los estudiantes a empresas en busca de talento. Si esto resulta cierto tendremos, por fin, una manera transparente de monetizar datos de usuarios que, además, articula un sistema de incentivos más que interesante para las tres partes (Udacity, estudiantes, empresas). Transparente porque el reto de Udacity no es otra que construir confianza por los dos lados convirtiéndose así en un Proxy de Dunbar.

Etiqueta: LAK12

Habitantes del país de los datos

Disfruto mucho con los posts de ribbonfarm. Aunque su longitud (que tiene dos medidas: largo o muy largo) echa para atrás, nunca me he arrepentido de leerlos. Leyendo sus reflexiones sobre historia tecnológica, uno se entera de cosas como que antes de la revolución industrial, se usaba jugo de cebolla para fabricar acero.

Ahora he descubierto –vía LAK12– que escribe, como contributor, en Forbes. Allí, sus dos últimos posts (1 y 2) son sobre la industria de los datos, a raíz del evento Strata.

En la era en que la vida privada se está convirtiendo en producto, es interesante comprender la lógica y los modelos de negocio (prácticamente sólo aplicables por organizaciones grandes, potentes y, a pesar de ello, innovadores) subyacentes de este proceso.

Pero lo que quería traer aquí es su mirada de antropólogo a los participantes de este tipo de eventos. Sus categorías ayudan a tomar con humor el –por lo demás siempre difícil o muy difícil– cambio en cualquier ámbito. En el país de los datos, donde lo que antes era análisis ahora es analítica y lo que era inteligencia de negocio ahora es big data, hay, según él, un sorprendente acuerdo tácito de que todos, absolutamente todos, son «científicos de datos» y que no hacen falta más títulos.

Y ahora, sus categorías (y que nadie se ofenda, por qué no tomárselo con humor).

- Los resentidos que se sienten marginados por la nueva tendencia.

- Los largamente ignorados que, de repente, se han convertido en estrellas y parpadean ante el foco de atención.

- Los que se sienten subestimados e impotentes.

- Los que no se pueden creer el poder que tienen de repente.

- Los que en su fuero interno se consideran falsos y hacia fuera se sienten o alegres o avergonzados.

- Listillos en proceso de cambiar el título que tuvieron en el último hype por uno del nuevo que le parezca.

- Los enfadados porque otras personas se quedan con el crédito de sus vinos por ponerlo en botellas nuevas.

- Mayores que insisten en que nada ha cambiado (entiéndase: «de modo que sigo siendo un experto»)

- Jóvenes que insisten en que todo ha cambiado (entiéndase: «los viejos no se enteran: contrátame a mí mejor»)

- Los fascinados por todo lo que es nuevo y brilla, entiéndanlo o no.

- Los hastiados que están de viaje pagado.

- Los megasociales para quienes todo es una gran fiesta.

Vueltas alrededor del futuro

Estoy dando vueltas a la idea de predecir el futuro. No soy ni de lejos la única. Predecir el futuro reduce el miedo ante la incertidumbre y es un gran negocio que está empujando la innovación del minado y la analítica de datos. Algo aplicable a una variedad de ámbitos.

Uno de los problemas bastante evidentes de las predicciones es que los datos que se usan para minar, analizar y predecir, son del pasado. Facebook y Google están al frente del aprovechamiento del pasado para personalizar la experiencia del usuario. Les pisan los talones miríadas de nuevas start-ups de analítica. Pero ojo. Esa personalización tiene un efecto secundario que merece ser examinado con cuidado.

En el ámbito de la educación, Ainhoa Ezeiza comentaba el otro día, refiriéndose al pensamiento de Vigotski, una cosa que me interesó.

(…) no se debe pensar que el futuro del alumno es una continuidad de lo que es, aunque es esto lo que presuponen la mayoría de los sistemas de evaluación. Es por eso que no es suficiente diagnosticar lo que los alumnos/as saben ahora, además es imprescindible estudiar qué es capaz de aprender con ayuda adulta/experta. Por lo tanto, la evaluación debe estar orientada al futuro, y no al presente, que es lo habitual. No es importante qué soy, sino qué puedo llegar a ser si me ayudan.

Personalmente me viene una cita de Nietzsche que dice que el futuro influye tanto en el presente que el pasado.

Die Zukunft beeinflusst die Gegenwart genauso wie die Vergangenheit.

Basarnos en el pasado para tomar decisiones es una solución muy muy seductora si estamos acampados a la sombra del Big Data. Pero tiene limitaciones y son serias. Lo comentaba el otro día en un post basándome en un trabajo de Danah Boyd y Kate Crawford.

Hoy me he encontrado con dos situaciones en las que creo que hay riesgo de darle al pasado un papel predominante en la toma de decisiones, con su consiguiente efecto empobrecedor.

- Una es la hipotética situación futura en que una persona que está disfrutando su seguro de desempleo, lo pierda por rechazar por tercera vez una oferta de trabajo «adecuada al perfil del parado» que le ofrezca una ETT. El artículo remarca que hará falta una «definición más precisa de lo que es una oferta de empleo adecuada que no se puede rechazar». Pero yo tengo mis dudas de que esto pueda definirse de manera satisfactoria para las instituciones, sin hacerla depender demasiado del comportamiento de la persona en el pasado. Lo que nos lleva a la situación de estar desincentivando que se interese y aprenda cosas nuevas.

- La otra también es del campo de los recursos humanos: resulta que analizar el perfil de Facebook de una persona informa mejor sobre qué tipo de empleado será, que los tests de inteligencia y personalidad. Indica su apertura a experiencias nuevas (fotos de unas vacaciones en Nueva Zelanda, con excursión a un glaciar), informa sobre su estabilidad emocional (¿tus amigos te envían mensajes de consuelo constantemente?) y su amabilidad (¿discutes a menudo con tu «amigos»?). Es taaan fácil hacer este análisis porque los datos están servidos. De ahí, de nuevo, el riesgo de darle demasiada importancia y contratar a personas por su comportamiento en Facebook en detrimento de conversar con ellos.

Además de Vigotski y Nietzsche, hay evidencias nuevas de que la manera de pensar en nuestro «yo» futuro, influye en decisiones importantes que tomamos en el presente, desde si contratar un seguro de pensiones hasta si realizar o no un acto poco ético.

Tenemos la oportunidad de construir ese «yo» futuro cada uno, cada día, ganándonos unos jeans gastados. El entorno, por supuesto, influye, y mucho, en ello. Creo que cuanto más nos tratan a base del pasado, más difícil será que tengamos una relación vivificante con el futuro y no tengamos que conformarnos con unos jeans que vienen ya gastados de fábrica. No es lo mismo.

Madrugones, viajes y datos libres

Hace poco me pegué un madrugón tremendo y crucé media ciudad para luego permitir que me corten y me hagan una herida que tarda en curarse más de un mes. ¿Suena a aventura masoquista? Era una prueba médica.

El resultado me lo darán a mí para que lo consulte con quien quiera. No tengo certeza pero supongo que estará hecho según unos estándares que permiten que cualquier especialista lo pueda interpretar. Lo contrario sería un lock-in y me crearía una dependencia de un sólo proveedor de servicios médicos. Decidirme por otro supondría un nuevo madrugón, un nuevo viaje…

El otro día, en el curso sobre analítica para el aprendizaje, me encontré con el proyecto APML, un estándar para el perfil de atención de las personas. Lo recuerdo de 2008, de mis primeras incursiones en la web 2.0. Veo que no ha avanzado nada desde entonces. Quizá un poquito, muy poquito.

Se trataba de una estándar que permitiera exportar de las plataformas centralizadas de «redes sociales», todos mis datos de atención: mis conexiones, conversaciones, etiquetas, clics, páginas vistas etc. Poder conocer, disponer de estos datos y poder llevarlos a otro sitio. Lo contrario es empezar desde cero una y otra vez. Un nuevo madrugón, un nuevo viaje…

Festival sobre los futuros de la formación online

A través de los organizadores del curso sobre analítica en el aprendizaje LAK12 me ha llegado noticia sobre una acción formativa online simpática: un festival de 48 horas y situado en tres continentes sobre los futuros de la formación online. El festival consistirá en 12 sesiones de 3 horas, cada una con una ponencia al comienzo, seguida por un debate. Creo que me conectaré a alguna. De entrada, hablar sobre los futuros de la formación online en un festival online y gratuito me parece simpático.

Efecto Hawthorne y analítica del aprendizaje

En la última sesión en vivo del curso sobre analítica del aprendizaje, alguien mencionó el Efecto Hawthorne. Éste consiste, grosso modo, en que las personas, si nos sabemos observadas, inevitablemente modificamos nuestro comportamiento. Somos así de sociales, en cuanto aparece otro, reaccionamos.

El Efecto Hawthorne se llama así a raíz de un experimento de los años 30 del siglo pasado, en la fábrica Hawthorne Works, a las afueras de Chicago. Consistió en observar qué efecto tenía en la productividad de los trabajadores aumentar o reducir la iluminación. Resultó que ambas cosas tenían el mismo efecto, pero que éste no se debió a los cambios en la iluminación sino al hecho de que las personas se sabían observadas.

El Efecto Hawthorne ocurre, por tanto, ahora mismo que escribo este post, sabiendo que ustedes lo leerán.

Para la analítica del aprendizaje es relevante en cuanto que las mediciones que posibilitan los entornos digitales, mucho más amplias que las que son posibles en el mundo físico, inevitablemente modificarán el comportamiento de los estudiantes. De hecho, es uno de los beneficios de la analítica: proporcionar evidencias para la autoreflexión, como parte fundamental del proceso de aprendizaje. La modificación del comportamiento bajo el efecto Hawthorne es deseable porque va vinculado al aprendizaje.

Los problemas surgen cuando una falta de transparencia impide que ocurra el Efecto Hawthorne. Cuando las personas son observadas sin la posibilidad de saberse observadas. Me resulta difícil imaginarme cualquier situación en que esto pueda ser realmente deseable. Mucho menos en el ámbito educativo. Sin embargo, si es un tema en un curso sobre analítica del aprendizaje, podemos suponer que está ocurriendo o puede ocurrir. O las dos cosas.

La tienda online Target consideró que era deseable desarrollar, a base de las trazas que las personas dejaban con sus compras, un algoritmo predictivo de embarazo que les permitía empezar a enviar ofertas específicas a embarazadas en su segundo trimestre y, así, aumentar sus ventas.

Una analogía en el campo educativo podría ser una universidad que desarrolla un algoritmo para predecir la probabilidad de abandono de la carrera, para intervenir a tiempo y así evitar la pérdida de ingresos por matrícula. Para complicar las cosas aun más, en ambos casos podría haber interés en vender los derechos de uso del algoritmo.

Tanto para la tienda online como para esa hipotética universidad, el Efecto Hawthorne sería un estorbo. Estamos ya lejos de las relaciones de confianza que requiere el proceso de aprendizaje. Hemos entrado en el terreno del control y las violaciones de la privacidad y éste supone, en el ámbito educativo, peligros parecidos que en cualquier otro ámbito de la vida.

Analítica libre para el aprendizaje

Es de esperar que el uso de la analítica suponga, cada vez más, una ventaja competitiva en el ámbito del aprendizaje y de la innovación. Por un lado, permite que las personas tengan mejores bases (evidencias) para la autoreflexión. Por otro lado, permite que las organizaciones tomen mejores decisiones sobre la generación de conocimiento.

De la mano de las nuevas oportunidades que abre la analítica —oportunidades de aprender mejor, pero también oportunidades de generar rentas—, surgen los riesgos habituales asociados a la centralización de la información: plataformas cerradas que crean dependencias a usuarios u organizaciones enteras y, en el peor de los casos, dejan a la persona, de cuyo aprendizaje se trata, fuera del valioso bucle de retroalimentación. Digo valioso porque es ahí donde ocurre gran parte del aprendizaje.

La contradicción entre el hecho de que en el mundo red, lo deseable es que las personas tengan actitud de propietario respecto a su aprendizaje —asumiendo la mayor parte de la responsabilidad— y la creación de dependencias y bucles de retroalimentación que les dejan fuera, es evidente.

Podría darse el caso de que, con la excusa de una mejora, lo que se consiga sea un entorpecimiento del aprendizaje por dejar fuera a los protagonistas: las personas. Tanto más fácil cuanto más lejos estén los accionistas de los proveedores de plataformas y soluciones de analítica, de los usuarios. Y, para qué nos vamos a engañar, lo normal es que estén lejos.

Por eso, una solución coherente con cómo funciona el aprendizaje es, siguiendo la filosofía del software libre, una analítica libre que incluye a las personas en la toma de decisiones. Es la solución que defienden los primeros teóricos de una pedagogía con lógica de redes, a la que interesará seguir prestando atención.

Rol del profesor en el aprendizaje en red: ser ejemplo

¿Cuál es el rol del profesor en el aprendizaje en red? Es una de las preguntas a responder al enfocar el aprendizaje en el siglo XXI. La respuesta que dan desde el conectivismo es que la noción del profesor resulta extraño si concebimos el mundo como red. Lo que cabe es el ejemplo, nodos —temporalmente— más fuertes y mejor conectados que otros. El ejemplo es, en mi opinión personal, lo que mejor ha funcionado siempre como «método pedagógico». Permite centrarnos no tanto en que alguien enseña o que alguien otro aprende, sino en la construcción conjunta de saberes. Permite que más Aes contraten a Aes y que a los Bes no les queden tantos Ces.

Pedagogías de la formación a distancia

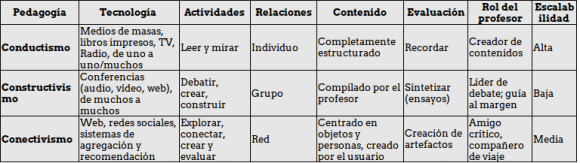

La tabla es de este trabajo que analiza las tres generaciones de pedagogía o andragogía —no sólo de la formación a distancia pero mejor observable en ese campo por el uso intensivo de la tecnología— a través del marco del modelo CoI. Son paradigmas que conviven. Lo importante es fijarse cómo quedan codificadas en las herramientas.

Algunas tecnologías puedes codificar pedagogías, endureciéndolas de ese modo. Es en este punto que, por necesidad, se convierten en influyentes en el diseño del aprendizaje, marcando el ritmo al que otros bailan.

Knewton: el sueño de la educación personalizada

Knewton es una plataforma de aprendizaje que, mediante algoritmos, consigue un nivel de personalización antes sólo alcanzable para el profesor en grupos muy muy reducidos. Personaliza tanto el contenido como el contexto, lo segundo en el sentido de que identifica los pares con un mismo estilo de aprendizaje. Para entornos tradicionales de educación, como nos cuenta una profe, es un sueño.

Creo que cabe la pregunta si merece la pena mantener estos entornos tradicionales basadas en la lógica de la era industrial. Hay quienes defienden que cada cerebro humano está cableado de una manera tan individual que ni siquiera los estilos de aprendizaje y las inteligencias múltiples son capaces de mapearlo. Si tomamos en serio estos argumentos, probablemente no merece la pena mantener, por ejemplo, la segregación o los contenidos por edades.

Pero lo que cabe preguntarse con respecto a Knewton, que entre sus muchas ventajas también promete una relación de por vida entre las personas y las editoriales, es quién será el propietario de los datos que recoge. ¿Lo serán los shareholders o los stakeholders de Knewton?